Pourquoi les récents développements de l’IA ouvrent la voie à des applications concrètes

Ces derniers temps, beaucoup ont constaté une accalmie dans les annonces concernant l’IA, surtout si l’on compare avec les sorties monumentales de GPT-3 en 2020 ou de GPT-4 en 2023. L’attente de GPT-5 a atteint une telle intensité qu’elle pourrait facilement inspirer une série Netflix. Les conversations bourdonnent autour de l’idée que l’IA pourrait atteindre un plateau, se situant au sommet du cycle de hype de Gartner. Cela a alimenté les spéculations selon lesquelles, dans les prochaines années, l’enthousiasme va s’estomper, la bulle d’investissement pourrait éclater et nous retournerons à nos vies quotidiennes, considérant cela comme un autre rêve fugace – ou un cauchemar, selon à qui vous vous adressez.

Mais voici le point important : des progrès plus significatifs ont été réalisés au cours de l’année écoulée que la plupart des gens ne le réalisent.

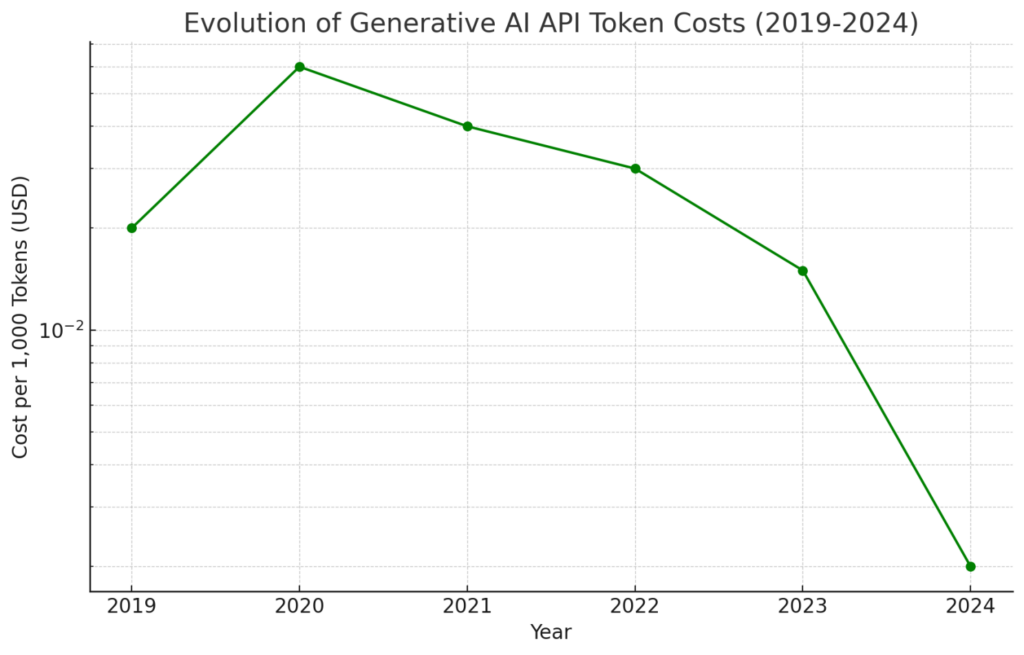

Tout d’abord, le coût d’exploitation de l’IA générative a chuté – d’un facteur dix en un an seulement. Cela s’explique en grande partie par le fait que les grands modèles deviennent plus petits et mieux optimisés, même si leur capacité d’analyse et de réponse continue de s’améliorer. Les progrès du matériel jouent également un rôle crucial, les entreprises mettant constamment à jour la technologie utilisée pour entraîner et exécuter ces modèles. L’ascension de NVidia pour devenir l’une des entreprises les plus valorisée au monde en témoigne, mais n’oublions pas les trublions comme Grok. Cette évolution continue est cruciale car elle ouvre la voie à l’utilisation de l’IA dans des applications où le coût et la vitesse de traitement sont primordiaux.

La qualité de l’IA a également fait un bond en avant : meilleures bases de connaissances, capacités multilingues et moins d’hallucinations. Les données utilisées pour entraîner ces modèles ont été méticuleusement optimisées et nettoyées, grâce aux générations précédentes d’IA. Nous générons et affinons maintenant des milliards de points de données pour entraîner de nouveaux modèles, une tâche si massive que seule l’IA peut la gérer. Les modèles d’aujourd’hui sont plus fiables, fonctionnent dans plusieurs langues et pays, et fournissent des réponses plus rapides et plus précises.

Un autre développement passionnant est l’essor des modèles multimodaux. Ces modèles ne se contentent pas de comprendre le texte ; ils peuvent désormais interpréter des images, des vidéos, des sons et même des entrées vocales. Cela élargit considérablement le champ des cas d’utilisation potentiels et prépare le terrain pour que les futurs modèles soient entraînés sur bien plus que du texte, comme c’était la norme auparavant.

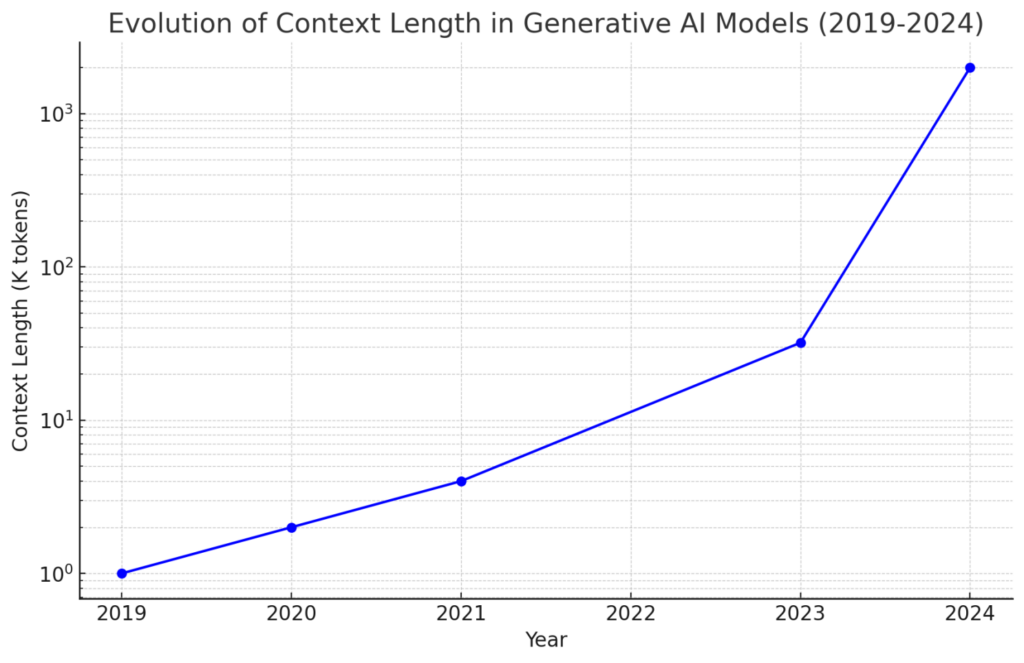

L’IA générative a également étendu sa capacité à traiter les données dans le cadre d’une seule requête ou invite. Il y a un an à peine, 32 000 jetons étaient la norme, ce qui suffisait à couvrir une partie importante du texte. Mais aujourd’hui, des modèles comme Google Gemini peuvent analyser jusqu’à 2 millions de jetons en une seule fois – nous parlons de traiter un film entier ou l’équivalent d’une bibliothèque de données en un seul prompt. Ce bond en avant dans la longueur du contexte était nécessaire pour tenir compte de l’évolution des capacités multimodales.

Un jeton (token en anglais) est un petit morceau de texte, comme un mot ou une partie de mot, que les modèles d’IA utilisent pour comprendre et traiter le langage. Il peut être étendu pour les images ou l’audio comme une petite partie des données.

De plus, la mise en cache du contexte est apparue comme un élément qui change la donne. Avec la capacité de traiter de vastes quantités de données sans nécessiter d’apprentissage spécifique ou de recherches de données externes (comme la génération augmentée par la récupération ou RAG), le défi consistait à gérer le temps et le coût associés au traitement de contextes aussi étendus. La solution ? La mise en cache. Une fois qu’un modèle a analysé un grand ensemble de données, celui-ci est enregistré en mémoire pour faciliter les requêtes multiples utilisant le même contexte. Cette innovation permet d’économiser de la puissance de traitement, d’accélérer les réponses, de réduire les coûts et de rendre les évolutions multimodales et à large contexte plus pratiques pour une utilisation réelle.

Aussi impressionnantes que soient les capacités d’interaction humaine de l’IA, la vraie magie opère lorsque ces modèles s’intègrent au monde numérique – dans le cadre d’applications SaaS ou d’usines digitales, par exemple. Pour cela, nous avons besoin de modèles qui comprennent les informations structurées et qui peuvent interagir de manière transparente avec les interfaces informatiques (API). C’est là qu’intervient « l’appel de fonction », où les modèles reçoivent un contexte sur les types de services auxquels ils peuvent accéder et sont ensuite capables d’utiliser ces services. L’application évidente est la recherche sur le Web ou l’intranet, mais cela va beaucoup plus loin. Ces modèles peuvent désormais interagir avec presque toutes les applications informatiques ou basées sur le cloud, ouvrant ainsi d’innombrables nouvelles possibilités.

L’évolution des capacités de raisonnement et de codage de l’IA est une autre étape importante. Si générer un poème est amusant, cela n’a pas beaucoup de valeur commerciale. En revanche, un modèle capable de comprendre un problème, de traiter les spécifications des besoins, de planifier et d’exécuter des actions, et même de générer du code à la volée pour résoudre des problèmes, change la donne pour les entreprises.

Je pourrais continuer – sur l’essor d’excellents modèles open-source de Meta, Mistral, Microsoft et d’autres, ou sur les modèles spécialisés qui excellent dans des tâches spécifiques, ou même sur les modèles plus petits qui peuvent maintenant fonctionner sur les derniers smartphones équipés de matériel de réseau neuronal dédié. Mais l’essentiel de mon argument est le suivant : les changements que nous avons observés au cours de l’année écoulée sont aussi cruciaux pour l’adoption de la technologie de l’IA que toute nouvelle percée spectaculaire. Ces développements indiquent que l’IA est en train de devenir mature et qu’elle est désormais prête à être intégrée dans les applications professionnelles. Il faudra du temps aux entreprises pour saisir pleinement le potentiel de cette technologie et repenser leurs applications pour l’exploiter, mais le moment est venu pour un véritable changement – au-delà du simple battage médiatique ou du buzz.

Et pendant que nous sommes occupés à mettre en œuvre cette incroyable technologie dans nos applications, qui a déjà le potentiel de bouleverser une grande partie de notre vie professionnelle, soyez assurés que les centres de recherches et les entreprises travaillent d’arrache-pied sur la prochaine génération. Ces avancées pourraient apporter un nouvel engouement au monde, peut-être même inaugurer l’AGI (Intelligence Générale Artificielle) ou la superintelligence. Mais il n’y a pas lieu d’être impatient. La révolution est déjà là.

Laisser un commentaire